祝贺!智能工程系石光明、吴金建教授团队在CCF-A会议/期刊AAAI 2025和IEEE TIP发表跨模态融合成像新方法

日期:2024-12-22 10:54 点击量:

石光明、吴金建教授课题组在基于动态差分信号的高质量成像方面取得了重要进展!研究成果发表在CCF A类期刊IEEE TIP 和A类会议AAAI 2025。

西电人工智能学院石光明教授和吴金建教授及团队长期从事长仿生成像及其智能信号处理等方面的理论和应用研究。课题组研制出基于能量差分型的动态感光芯片,颠覆了基于能量积分的传统静态感光模式,具有成像速度快(∼10µs)、延迟低、动态范围大(∼120dB)等特性,突破传统成像速度与动态范围限制。在此基础上,团队近期提出了动-静双模态(传统相机+动态差分相机)协同感光成像方法,探索双目系统下异构信号互补特征融合理论与方法,实现高分辨率、大动态范围、高速的高质量成像,原理样机如图1所示。

图1 高速、高分辨、高动态混合成像系统

基于该成像系统,课题组提出了一种新颖的帧-事件融合框架(FEF-Deblur),通过并行自我关注和交叉关注机制,有效分离和聚合互补特征,同时引入递归交叉注意力保留时空信息,以提升运动去模糊性能。实验表明,所提的方法优于最先进的基于事件和基于图像/视频的方法。相关成果发表在计算机视觉国际顶级期刊IEEE TIP(IEEE Transactions on Image Processing)。(团队杨文博士后为第一作者,吴金建教授为通讯作者。)

图2 FEF-Deblur 研究方法框架

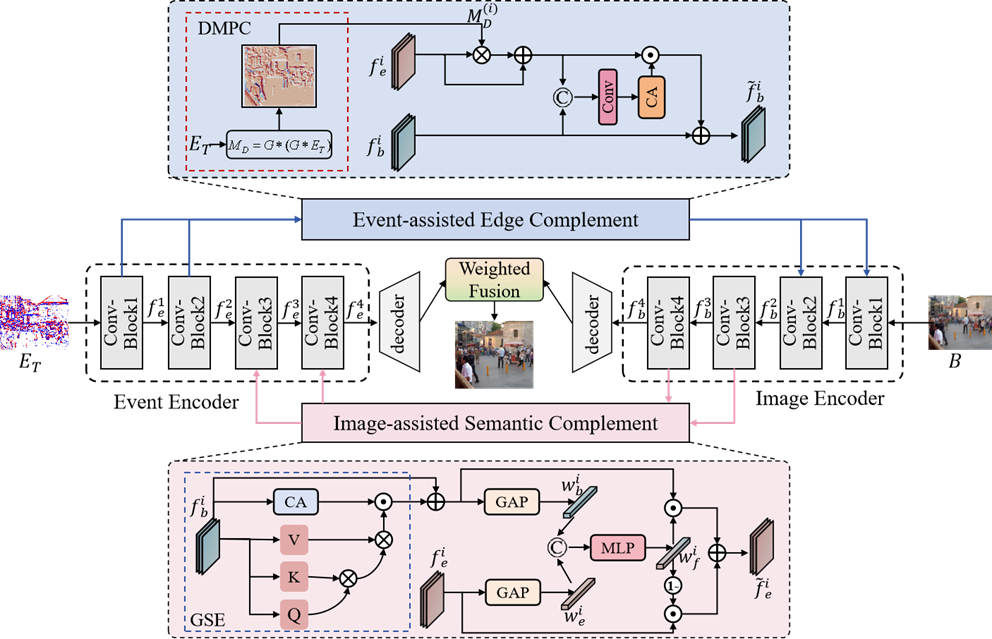

进一步地,课题组持续改进跨模态融合方法,提出了非对称层级差异交互网(AHDINet),对跨模态层级特征进行差异互补建模:在浅层编码器利用事件模态增强图像特征的边缘细节,在深层编码器阶段将图像特征的上下文语义转移到事件分支。相关研究成果发表在人工智能领域最具影响力的国际学术会议之一AAAI 2025(The 39th Annual AAAI Conference on Artificial Intelligence)。(团队杨文博士后为第一作者,吴金建教授为通讯作者。)

图3 AHDINet 研究方法框架